智通财经APP获悉,美国科技巨头微软公司(MSFT.US)在美东时间周一重磅推出其升级换代后的第二代人工智能芯片(AI芯片),这是该科技巨头推动以更高能效比与性价比算力路径为其云端AI训练/推理算力资源服务提供的至关重要自研AI算力集群硬件,并为售价昂贵的英伟达AI GPU系列人工智能算力集群提供替代型AI算力基础设施解决方案的核心举措。

这款由“全球芯片代工之王”台积电所制造的名为“Maia 200”的微软自研AI芯片(与谷歌TPU架构类似,走的是AI ASIC技术路线),正陆续进入微软位于爱荷华州的大型AI数据中心,下一步的大规模部署将转向凤凰城地区的某个大型数据中心。微软在当地时间周一邀请开发者们积极使用围绕Maia的专属控制软件,但目前尚不清楚微软Azure云计算服务平台的庞大用户们何时能够精准调用/使用搭载该AI芯片的云端AI服务器算力集群。

毋庸置疑的是,席卷全球的生成式AI热潮加快了云计算与芯片设计巨头们的AI ASIC路线云平台内部专属AI芯片开发进程,它们正争相为先进的大型AI数据中心设计出速度最快且能效最为强劲的高性价比AI算力基础设施集群。美国芯片设计巨头迈威尔(MRVL.US)及其最大竞争对手博通公司(AVGO.US),以及来自中国台湾的联发科,愈发转向聚焦于携手亚马逊、谷歌等云计算巨头们共同打造出根据其AI数据中心具体需求量身定制的AI ASIC算力集群,而这项ASIC业务已经成长为这三家专注设计的芯片巨头一项非常重要业务,比如博通联手谷歌所打造的TPU AI算力集群就是一种最典型的AI ASIC技术路线。

云计算三巨头中的最强AI ASIC! 拳打亚马逊Trainium,脚踢谷歌TPU

继谷歌与亚马逊近期纷纷发布新一代性能大幅升级的云计算平台内部专属AI ASIC芯片之后,同为全球云计算“三巨头”的微软传闻已久的Maia 200 新一代高性能AI芯片产品终于问世。

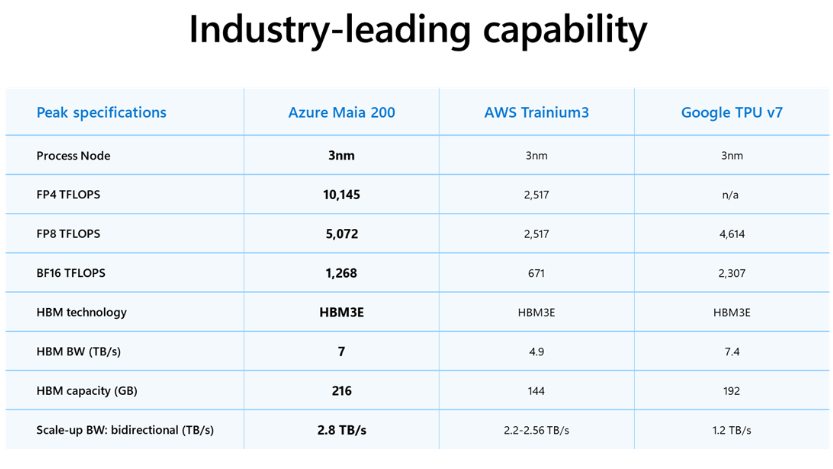

微软在一份公告中表示,这款“为天量级AI推理任务而生”的AI芯片在多项测试中超越亚马逊最新推出的第三代Trainium以及谷歌前不久所推出的第七代TPU。因此,微软官方将刚刚重磅推出的Maia 200称为“所有超大规模云计算服务商中性能最强的自研内部专属AI芯片”。

微软云计算与人工智能负责人斯科特·古思里(Scott Guthrie)在一篇博客文章中表示,由台积电代工的首批AI芯片设备将提供给微软的超级智能团队,用于大规模生成数据与执行庞大AI训练工作负载以改进微软的下一代AI大模型。该AI芯片也将用于为企业版Copilot AI助手系列产品以及微软内部的托管型AI推理服务系列产品提供云端AI算力基础设施集群支撑,其中也包括微软向云计算客户们出租的OpenAI最新GPT系列AI大模型。

虽然微软的自研AI芯片推进计划启动时间,晚于另外两大全球云计算领军者——亚马逊AWS以及Alphabet旗下谷歌云计算平台GCP开启云平台内部专属自研AI芯片的正式部署时间,但是这三家云计算超级巨头可谓有着相似的目标:打造最具备成本效益、能够无缝接入庞大数据中心的云计算机器,并为云计算客户们带来显著的成本节约与其他关键层面的能效大幅提升。此外,英伟达最新推出且行业领先AI芯片算力集群的极高成本与持续供给短缺,推动了云计算市场争相寻找更加廉价且颇具能效比的替代算力来源。

微软表示,这款新推出的云计算专属AI芯片在大部分AI推理任务上的性能优于谷歌和亚马逊云计算服务的同类半导体设备。“Maia 200 也是微软迄今部署过的最高效人工智能推理系统。”古思里表示,他所指的推理工作负载是使用AI大模型生成对查询的回应类似AI推理进程。

据了解,Maia 200每美元性能比微软当前最新一代硬件提升30%,该AI芯片在FP4精度下的整体推理性能是第三代亚马逊TrainiumAI ASIC云计算内部专属自研AI芯片的足足三倍,FP8性能则超过谷歌第七代TPU。微软已向软件开发者、学术界和前沿AI实验室开放Maia 200软件开发工具包的预览版,并计划“未来一段时间向更多客户开放”该AI芯片的云端服务器租用。

据斯科特·古思里在微软官方博客中的介绍内容,Maia 200采用台积电最尖端的3nm先进制程工艺所制造,每颗芯片包含超过1400亿个晶体管。该AI芯片专为大规模AI推理工作负载定制,在4位精度(FP4)下可提供超过10 petaFLOPS的算力,在8位精度(FP8)下提供超过5 petaFLOPS的性能,所有这些性能都在750瓦的芯片功耗范围内实现。

除了芯片本身的算力外,微软也在存储系统参数上大举加码。该公司披露,Maia 200配备216GB、带宽达7TB/s的HBM3e,以及272MB的片上SRAM。在系统拓展层面,每块芯片提供2.8TB/s的双向专用扩展带宽,支持在6144个加速器集群中提供可预测的高性能集合操作。这些强劲的参数以及本身强大算力,解释了为何Maia 200推理性能跑分大幅跑赢亚马逊第三代Trainium与谷歌第七代TPU。

此外,微软在博客中表示,该科技巨头已经在着手设计该AI芯片的继任者——名为Maia 300的下一代AI芯片。如果内部研发进展受挫,微软也还有其他选择:作为与最紧密合作伙伴OpenAI此前达成重磅协议的一部分,微软可以获取这家ChatGPT开发商处于萌芽阶段的独家自研AI芯片设计方案。

来自市场研究机构Gartner的资深分析师奇拉格·德卡特(Chirag Dekate)表示,Maia 200的重磅发布显示微软对其造芯工程是非常认真的。他强调,大型AI数据中心不断增长的能耗需求,以及全球许多地区缺乏新的电力来源,使得像Maia这样以性价比和高效率为核心的AI算力项目更加关键。“如果你只是做一两次噱头式活动,你不会进行这种大规模投资,”德卡特表示。“这是一项跨多代的且战略性的投资。”

属于AI ASIC技术路线的盛世已经到来

毫无疑问的是,经济性与电力层面的重大约束,迫使微软、亚马逊、谷歌以及Facebook母公司Meta都在推AI ASIC技术路线的云计算内部系统自研AI芯片,核心目的都是为了AI算力集群更具性价比与能效比。

类似“星际之门”的超大规模AI数据中心建设成本高昂,因此科技巨头们愈发要求AI算力系统趋于经济性,以及电力约束之下,科技巨头力争把“单位Token成本、单位瓦特产出”做到极致,属于AI ASIC技术路线的繁荣盛世可谓已经到来。

此外,类似英伟达Blackwell架构先进AI GPU算力集群的长期供不应求、成本高昂且受制于供应链瓶颈与交付节奏,自研AI ASIC无疑能提供“第二曲线产能”,并在采购谈判、产品定价与云计算服务毛利层面更主动,叠加谷歌、微软等云计算大厂们能把“芯片—互联—系统—编译器/运行时—调度—观测/可靠性”一体化共设计,提高算力基础设施利用率并降低TCO。

微软把 Maia 200的定位直接写成“显著改善AI token generation的经济性”,并多次强调performance per dollar;AWS 也把 Trainium3 的目标写成“best token economics”,并用能效/性价比作为卖点;谷歌云计算平台则将Ironwood定义为“人工智能推理时代”的专用 TPU(TPU也属于AI ASIC技术路线),强调能效与大规模推理服务。

随着DeepSeek彻底掀起AI训练与推理层面的“效率革命”,推动未来AI大模型开发向“低成本”与“高性能”两大核心聚焦,相比于英伟达AI GPU路线更具性价比优势的AI ASIC在云端AI推理算力需求猛增的背景之下,迈入比2023-2025年期间AI热潮时期更加强劲的需求扩张轨迹,未来谷歌、OpenAI以及Meta等大客户有望持续斥巨资携手博通开发AI ASIC芯片。

根据Semianalysis测算数据,谷歌最新的TPU v7 (Ironwood) 展现出了惊人的代际跨越,TPU v7的BF16算力高达4614 TFLOPS,而上一代被广泛使用的TPU v5p仅为459 TFLOPS,这堪称是整整一个数量级的提升。此外,TPU v7显存直接对标英伟达Blackwell架构的 B200,针对特定应用,架构上更具性价比与能效比优势的AI ASIC可以更容易地吃下主流推理端算力负载,比如谷歌最新TPU集群甚至能提供比英伟达Blackwell高出1.4倍的每美元性能。

英伟达AI GPU几乎垄断的AI训练侧需要更加强大的AI算力集群通用性以及整个算力体系的快速迭代能力,而AI推理侧则在前沿AI技术规模化落地后更看重单位token成本、延迟与能效。谷歌明确把Ironwood定位为“为AI推理时代而生”的TPU代际,并强调性能/能效/算力集群性价比与可扩展性。

谷歌在11月下旬重磅推出Gemini3 AI应用生态之后,这一最前沿AI应用软件随即风靡全球,推动谷歌AI算力需求瞬间激增。Gemini3 系列产品一经发布即带来无比庞大的AI token处理量,迫使谷歌大幅调低Gemini 3 Pro与Nano Banana Pro的免费访问量,对Pro订阅用户也实施暂时限制,叠加韩国近期贸易出口数据显示SK海力士与三星电子HBM存储系统以及企业级SSD需求持续强劲,进一步验证了华尔街所高呼的“AI热潮仍然处于算力基础设施供不应求的早期建设阶段”。

英伟达前不久与AI芯片初创公司Groq达成的200亿美元非独家授权合作协议,将其AI推理技术授权给英伟达,并且在交易完成后Groq创始人及核心研发团队将加入英伟达,可谓共同凸显出随着“全球AI推理大浪潮”全面来袭,叠加谷歌TPU AI算力集群带来的越来越大竞争压力,英伟达力争通过“多架构AI算力+巩固CUDA生态+引进更多AI芯片设计人才”来维持其在AI芯片领域高达90%市场份额的绝对主导权。

摩根士丹利近日发布的一份研报显示,谷歌TPU AI芯片的实际产量在2027年和2028年将分别达到500万和700万块,较该金融巨头此前给出的预期可谓分别大举上修67%、120%。而这一产量激增预期可能预示着谷歌将开启TPU AI芯片的直接对外销售。更具基本面冲击力的是,大摩的这份研究报告测算每50万片TPU外销,便有望为谷歌带来130亿美元的额外营收以及高达0.40美元的每股收益。